Die Funktion „Generatives Füllen“ erobert aktuell das Netz. Benjamin überlegt, welche neuen Möglichkeiten die Integration von Firefly in Photoshop wirklich bringt.

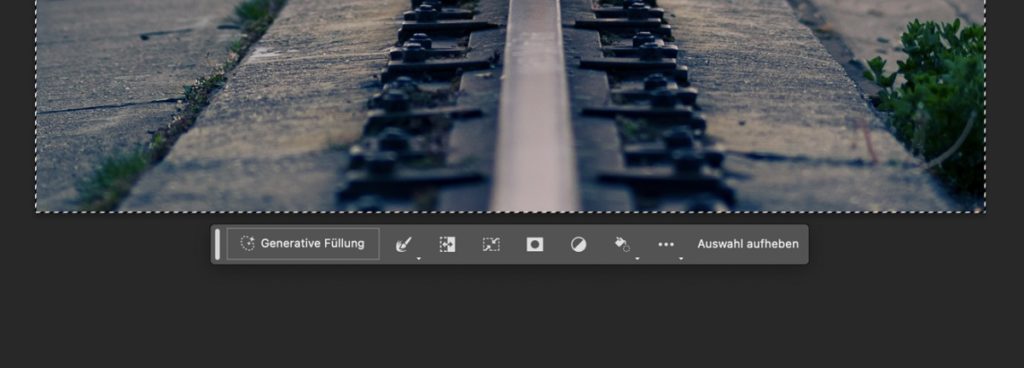

Zumindest zu Werbezwecken hat sich Adobes Integration seiner Firefly-KI in Photoshop ganz sicher schon gelohnt. Aktuell veröffentlicht so gut wie jeder namhafte YouTuber und jedes renommierte Magazin Artikel zur Funktion „Generatives Füllen“, die wie von Zauberhand Objekte in Bilder rein und auch wieder raus generiert. Auch ich habe mir die benötigte Beta installiert und ausprobiert, wie sich „Generatives Füllen“ im Alltag nutzen lässt.

Wollt Ihr sie lieber schnell selbst ausprobieren? Dann steuert die Adobe-Cloud-App an, falls Ihr das entsprechende Abonnement besitzt. Dort findet Ihr in der App-Übersicht die Kategorie „Beta“ und dort könnt Ihr die neueste Beta-Version von Photoshop herunterladen.

Und falls ihr Photoshop noch nicht besitzt, dann werft mal einen Blick in diesen Artikel von Mark. Dort erklärt er euch, wie sich beim Kauf von Lightroom und Photoshop sowohl als Neukunde als auch als Bestandskunde bares Geld sparen lässt.

Vorwort: Falls Ihr gar nicht wisst, worum es bei „Generatives Füllen“ geht

Mit der Funktion „Generatives Füllen“ verknüpft Adobe die Software Photoshop mit der eigenen Bildgenerierungs-KI „Firefly“. Diese steht zwar schon länger im Netz zur Verfügung, mit einer direkten Software-Integration ist Adobe aber eine wichtige Übertragungsleistung gelungen. Denn hierdurch lassen sich KI-generierte Elemente in bereits aufgenommene oder gerenderte Bilder hineinsetzen. Tatsächlich lag auf dem Beitragsbild dieses Artikels gar kein Huhn auf meinem Sofa. Die Statue, das Dach samt Fenster, der Kaffeebecher sowie Zauberstab und Kamera sind ebenfalls KI-generiert.

Alternativ konnte ich mir auf dem Bild weiter unten mit wenigen Klicks einen schmucken Vollbart stehen lassen. Das Porträt habe ich vor einigen Monaten aufgenommen, ich musste für Photoshop also weder auf die Eigenschaften der Datei noch auf die Komposition achten. Stattdessen zieht man einfach einen groben Rahmen und den Bereich, in dem das neue Element erscheinen soll und tippt den gewünschten Befehl zur KI-Generierung („Prompt“) in eine neue Befehlszeile ein.

Als Informationsgrundlage verwendet Adobe seine eigene Datenbank an Stock-Photos. Veränderte Bilder sind daher gefahrlos auch kommerziell nutzbar. Das ist eine wichtige Voraussetzung für das Vorhaben, Generatives Füllen auch tatsächlich zu einem sinnvollen Werkzeug in der Bildbearbeitung zu machen.

Neben dem Einsetzen neuer Elemente lässt sich Generatives Füllen auch zum intelligenten Entfernen von störenden Bildelementen nutzen. Dazu aber später, erst einmal schauen wir uns das Einsetzen neuer Bildelemente an.

Einsetzen von KI-generierten Elementen

Ein kurzer Hinweis vorab: Das Herumspielen mit „Generatives Füllen“ macht an den ersten Tagen alles andere als produktiv. Denn die Ergebnisse sind teilweise dermaßen interessant, dass ich mich häufiger im Generieren neuer Elemente verloren habe. Das liegt zum Teil daran, dass die Ergebnisse unterhaltsam und kurios waren. Andererseits sehen eingesetzte Elemente verblüffend echt aus.

Denn Photoshop liefert der Firefly-KI Informationen aus den bearbeiteten Bildern, wodurch der Lichteinfall oder auch Schatten in vielen Fällen realistisch aussehen. Auch dann, wenn man wie oben einen Affen auf einem Fahrrad generiert. Umliegende Objekte werden, falls nötig, leicht abgewandelt, um Übergänge weicher zu machen oder einen Kontext zur Umgebung herzustellen. Denn auch das erste Auto auf der linken Seite habe ich künstlich eingesetzt.

Meiner Meinung nach liegt hier die eigentliche Innovation von Generatives Füllen – denn was Photoshop aktuell noch in Eure Bilder einsetzt, sieht oft deutlich unrealistischer aus als KI-generierte Bilder von Konkurrenten wie Stable Diffusion oder Midjourney. Dabei ist es nur eine Frage der Zeit, wann Photoshop aufholt – eine Anwendbarkeit zu schaffen, ist bei KI-Generatoren schon eine deutlich größere Herausforderung. Und das muss die Konkurrenz trotz besserer Ergebnisse erst einmal schaffen.

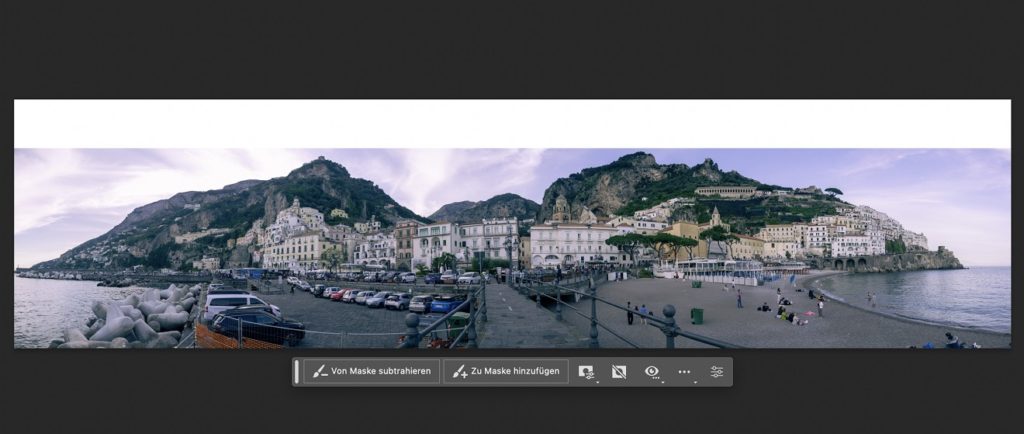

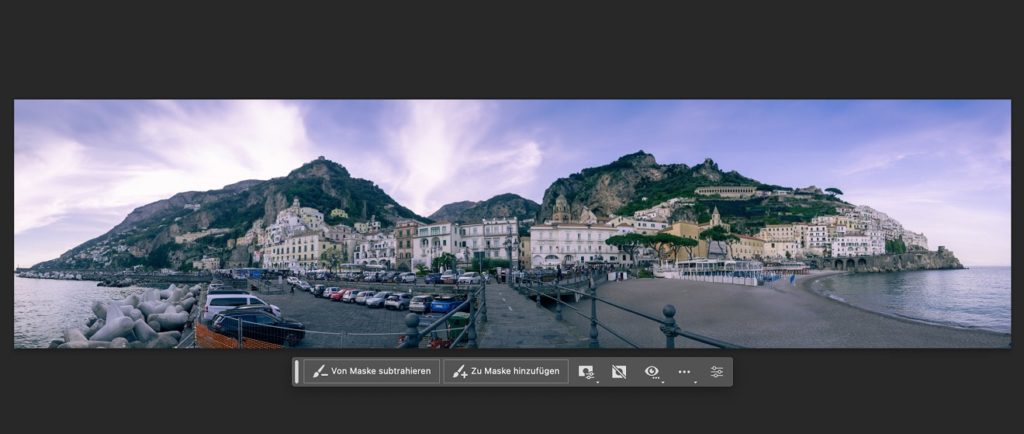

Zumal Photoshop generierte Bildelemente immer als neue Masken einfügt. Dadurch hat man die Möglichkeit, mit wenigen Klicks Übergänge zu verfeinern oder die Belichtung zu verändern. Im Bild mit den KI-generierten Schafen habe ich beispielsweise noch einmal die Belichtung korrigiert und die Maske so verkleinert, dass Photoshop die Details im Horizont nicht „KI-verhunzt“. Das geht alles dermaßen gewohnt von der Hand, dass man mit ein wenig Photoshop-Erfahrung gar nicht wirklich drüber nachdenkt.

Das Einsetzen KI-generierter Elemente ist aber aktuell eher beeindruckend als nützlich. Denn die Ergebnisse sehen beim genauen Hinsehen noch zu künstlich aus als dass sie digitales Compositing ersetzen würden. Hier wünsche ich mir zukünftig die Möglichkeit, die Künstliche Intelligenz mit Informationen aus eigenen Bildern anzureichern. Sprich, dass ich mich selbst aus Bildern von meiner Festplatte über Generatives Füllen in meine Fotos einsetzen kann. Da Stable Diffusion sowas bereits beherrscht, ist aber auch das nur eine Frage der Zeit.

Erweitern und Herausrechnen von Elementen

Aktuell sehe ich den Vorteil von „Generatives Füllen“ in der Bildbearbeitung daher noch woanders. Denn das Tool ist eine kleine Revolution, wenn es darum geht, störende Elemente aus Bildern herauszurechnen oder Fotos über den Bildrand heraus zu erweitern. Das kann Photoshop zwar schon länger mit ein paar einfachen Klicks, die Ergebnisse überzeugen dabei aber weniger. Zwar bot Photoshop bislang schon eine gute Grundlage, um händisch nachzubessern, Generatives Füllen setzt hier aber wirklich neue Maßstäbe.

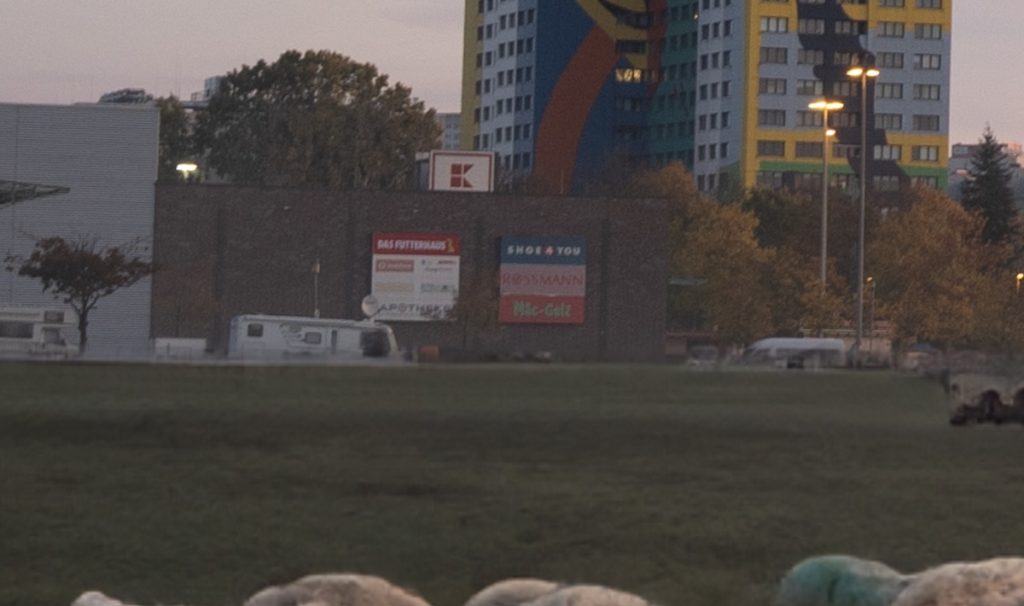

Denn dadurch, dass Photoshop beim Füllen nicht mehr allein auf Informationen innerhalb des vorhandenen Bildes zurückgreift, sind die ausgefüllten Bereiche deutlich realistischer und vor allem weniger repetitiv. Im Beispiel mit Blick auf den Berliner Fernsehturm sieht man das am Bildrand sehr gut: Das inhaltliche Füllen (rechts), das nur auf lokalen Bildinformationen basiert, setzt beim Füllen immer den gleichen Bildbereich ein. Das Generative Füllen (links) hingegen berechnet die fehlenden Bildbereiche abwechslungsreicher, was oftmals deutlich realistischer sein dürfte. Das Werkzeug ist dabei sogar leistungsstark genug, um ein Bild im Porträtformat in ein 16:9-Format umzuwandeln:

Links seht Ihr das vorherige Bild und Photoshop hatte tatsächlich nur dieses Foto als Informationsgrundlage zur Verfügung. Auch Geodaten zeichnet die Sony Alpha 7 II nicht auf, die ich zur Aufnahme verwendet habe. Das rechte Bild habe ich mit vier Anwendungen von „Generatives Füllen“ erzeugt – einmal wurde das Bild in 16:9 umgewandelt, dann habe ich noch dreimal ausbessern müssen.

Zu guter Letzt könnt Ihr störende Bildelemente auch sehr zuverlässig aus Fotos herausrechnen, wenn Ihr die Befehlszeile für das Generative Füllen leer lasst. In meinem Beispiel wollte ich auf die Schnelle die großen Stromkabel entfernen, jeweils habe ich dabei die Kabel grob mit dem Polygon-Lasso umrandet. Das Ergebnis ist sehr gut, selbst die Blätter der Bäume werden realistisch nachgebildet. Nur bei den kleinen Kabeln vor dem Haus und den Bäumen müsste ich nochmal nachbessern.

Beeindruckend ist zudem, dass schon die Beta-Version mit sehr großen Bildern umgehen kann. Mein Panorama aus Amalfi etwas weiter unten ist etwa 70 Megapixel groß und das Werkzeug schafft es in derselben Zeit, Elemente ohne Qualitätsverlust zu füllen. Hier hätte ich im Vorfeld erwartet, dass die Photoshop-Beta ruckelt oder abstürzt oder das Generative Füllen länger dauert. In der Praxis war das einzige Problem jedoch, dass die Festplatte meines Notebooks zu voll war, dass Photoshop die großen temporären Dateien zwischenspeichern konnte.

Fazit

Meiner Meinung nach ist es durchaus berechtigt, dass aktuell jeder über die neuen KI-Funktionen in Photoshop berichtet. Aber weniger aus den Gründen, die dabei meist im Fokus stehen. Ja, es ist spaßig und flashig, neue Elemente wie von Zauberhand in bestehende Bilder einzufügen. Und irgendwann werden die erstellten Elemente auch eine Qualität erreichen, dass wir sie kaum von realen Motiven unterscheiden können – das sehen wir bereits am leistungsstärkeren Midjourney und Beispielen wie dem Papst im teuren Styler-Outfit.

Deutlich interessanter finde ich Adobes KI-Integration allerdings, da sie bestehende Funktionen in Photoshop noch leistungsstärker macht. Bilder binnen Sekunden aus dem Hochformat ins Querformat zu bringen oder störende Elemente ohne langes Stempeln herauszurechnen, macht das Bildbearbeitungsprogramm zu einem noch besseren Werkzeug.

Gleichzeitig achtet Adobe bei seiner Integration darauf, dass die Bilder uns lizenztechnisch keine Schwierigkeiten bereiten. Ich bin daher wirklich gespannt, welche kreativen Einsatzmöglichkeiten Adobe für seine Firefly-KI in Zukunft noch hat. Was meint Ihr? Wird der aktuelle KI-Trend vorübergehen oder ist das die neue Innovation, auf die wir lange gewartet haben?

PS: Eine Sache habe ich von Anfang an verschwiegen! Schaut noch einmal auf mein Bart-Bild – hier habe ich ganz klammheimlich auch mein schwarzes T-Shirt durch einen Anzug ersetzt. Habt Ihr’s gemerkt? Schreibt’s mir in die Kommentare!

Tja wer nicht fotografieren kann,braucht eben so ne Scheiß. Für jeden ernsthaften Fotografen ein NoGo. Mit dieser Technik arbeiten nur Stümper. Das ist meine Meinung.

Zum Glück gibt es ja immer noch Leute, die Fotografieren können.

Wenn ich damit Drähte und alles überflüssige schneller entfernen kann – ist das eine gute Sache.

Ich wehre mich allerdings dagegen das Leute Bilder zusammen „matschen“ und das am Ende als Photographie verkaufen wollen!

Was wir tun sollte immer und weiterhin malen mit Licht sein und sich schon in seiner Bezeichnung und Kunstform von KI Bildern unterscheiden.

„Wenn ich damit Drähte und alles überflüssige schneller entfernen kann – ist das eine gute Sache.“

dann würde es die ganze Stimmung ruinieren wenn ich zB. ein Dorf in Osteuropa fotografiere

Manchmal gehören die Drähte und der „Quatsch“ ins Bild und manchmal stört es halt. Je nach Bild/Motiv/Stimmung.

naja wenn ich ein Dorf ohne Drähte fotografieren möchte dann tue ich das zB. in Deutschland 😉

Ich meinte das nicht örtlich/geografisch und spreche auch nicht von ganzen Dörfer fotografieren, sondern, manchmal fotografiert man eine Landschaft und irgendwo in der Ecke lässt sich nicht vermeiden, dass da noch ein paar Drähte die Ecke schneiden, oder eine Strassenlampe die am Rand noch reinrutscht, oder man übersah bei der Aufnahme den Abfallkübel unten am Bildrand, der noch frech reinguckt usw…

Wie gesagt: je nach Motiv/Bild/Stimmung gehören solche Sachen halt ins Bild oder sie stören.

Aber jeder wie er will.

👍

Hi Cat: ich gestehe, für mich geht das nicht – verstehen kann ich es zwar, aber der Kontext des Hauptmotivs wird dabei eben stark verändert. Beispielsweise „Drähte/Leitungen“ oder ?“Überflüssiges“? entfernen. D.h. der Greif flog in einem menschgemachten ländlichem Kulturraum und auf dem ausgespielten Bild, sieht aus; als wäre es ein naturbelassener Lebensraum. Schwierig. Klar wird gefordert von Auftraggebern und ist natürlich auch bei reiner Illustration von Artikeln als Freisteller absolut okay, aber bei „für sich alleine stehenden Bildern“ eben schwierig hinsichtlich Einordnung …

Erlaubt ist, was gefällt!

Ach, du bist das. Der mit den Glasplatten und dem schwarzen Tuch über dem Kopf.

Und wer mit einer digital Kamera oder Smartphone fotografiert ist auch kein ernsthafter Fotograf?

„Wird der aktuelle KI-Trend vorübergehen oder ist das die neue Innovation, auf die wir lange gewartet haben?“ – leider ist da „nix“ was vorübergehen wird, es ist das erwartete, schleichende Ende jeglicher Glaubwürdigkeit ob nun mit Ps, ChatGPT & Co.

Und es sind natürlich „phantastische Creator-Möglichkeiten“, die uns Rezipienten zunehmend „den Glauben an die Wahrhaftigkeit“ einer visuellen, textlichen oder gehörten Imformation berauben werden.

Die Wedding-, Mode- & Lifestyle-Fotografen werden es genauso zu spüren bekommen wie die Reportagespezialisten – was nicht passt, wird passend gemacht.

Es wird schwierig … für unsere Kinder und Enkelkinder.

Bedauerlicherweise hatte dieser immer wiederkehrende Hinweis auf Glaubwürdigkeit, Wahrhaftigkeit, Realität seit dem ersten Foto in Frankreich keine Grundlage. Auch – hier, der Analoghinweis der stehts seine Betrachtung bekommt hat nie seine Richtigkeit. (Retusche, Colorieren, beschneiden usw.) Lassen wir also den „Glauben“ doch einfach dahin, wohin dieser sich hinwendet – in die Kirchengemeinde. Werkzeuge haben sich im Laufe der Zeit immer gewandelt. So auch die der Auf- und Wiedergabegeräte. Es hat immer und in jeder Zeit Menschen gegeben, die mit den aktuellen Gegebenheiten, Werkzeugen ausgezeichnete Ergebnisse abgeliefert haben. Und, um den Umstand der Fälschung Rechnung zu tragen – „MI“ schafft es letztendlich immer, diese zu erkennen. Man muss sich nur die Mühe machen, sich Gedanken über „Fälschung“ zu machen. Bekomme ich eine Dissertationsabgabe mit „kopierten“ Inhalten, so sind diese zu erkennen. Sind hingegen einzelne Wortzufügungen, oder um „im Bilde“ zu bleiben, einzelne Elemente neu zusammengefügt, so haben wir es mit einer „Neufassung“ zu tun. Die Zeiten der Universalgenies sind lange vorbei, Oder besser, diese hat es nie gegeben. Es gab – und gibt immer „denkend eingeschränkte“ Mitmenschen. Diese wurden, werden dann leider als Maßstab herangezogen. Ja, dieser Umstand macht es für unsere Kinder und Enkelkinder schwierig. Aber nicht irgendwelche Werkzeuge.

‚“Denkend eingeschränkte“ Mitmenschen“ – ach, du heiliger Akademiker-Maßstab, ich „glaube“ es nicht!

😂

Also nun bleib aber mal fair, Du alter Stänkerfritze, was heißt denn nun „Akademiker-Maßstab“?

Denkend eingeschränkte Mitmenschen gibt es ja nun nicht nur bei den Akademikern, die fallen eben nur mehr auf, aber dieses Problem ist auch in anderen Gewerken vorhanden.

Aber hilf mal einem weiter, der noch platter in der Birne ist als Du! „Dissertationsabgabe“, was ist denn dies? Ist das so was wie eine beim Fußball zu hoch rein gegebene Bananenflanke, die man dann mit den scheppen Füßen nur noch übers Ziel (beim Fussball eben das Tor) hinaus schießen kann?

🤔 Ehrlich Leonhard: da musst Du schon den „Professor“ hier fragen – nicht meine intellektuelle Ebene – ich hätte meine imaginäre Dissertation „Die reziproke Relation subterrarer Agrarpolitik zur spirituellen Kapazität seiner Produzenten und die Folgen daraus für die Kartoffelindustrie“ sicher eingereicht – aber meinen Löffel werde ich irgendwann mal abgeben. Versprochen. 😉

Mit dem Löffel abgeben warte noch einen Augenblick, schreibe gerne mit Dir, werter Freund! Nebenbei, bemerkt, ich frage nie einen Professor, bevor ich mir sicher bin, dass der einen Fachbereich hat, welchen ich für ernst zu nehmende Wissenschaft halte, da bin ich eigen! Hab da mal böse Erfahrungen gemacht, in einem kalten Winter brannte es da, wo man sich gern zur Ruhe setzt, da dies Gefühl nun nicht so angenehm ist schweifte mein Blick durch den Schilderwald, endlich, ein Doktor meiner Wahl hatte sein großes Werbeschild an die Hauswand gemacht. Ich rein zu dem, Hose runter und sprach: „Medizinmann, schau Dir mal meine Winterkirschen an, die brennen wie das Fegefeuer!“ Erst holte der erschütterte Aggademigger tief Luft und dann hat der mich vielleicht angekeift: „Sie ungebildetes nichts, was glauben Sie, was ein Archäologe mit ihren ordinären Gesäß zu tun hat?“ Meine Entschuldigung, dass sich der einfache Mensch ja nicht alles merken kann, wo doch heute so viele Studiengänge für den Arsch sind hat der auch noch falsch verstanden und mich aus der Praxis, welche wohl gar keine war, geschissen. Aber die Sache ging gut aus, kam an einem Werbeplakat vorbei, da stand „Faktu und Hämorrhoiden geben Frieden“, hab gleich mit… Weiterlesen »

🤔 Da fällt mir nix mehr zu ein – zumindest Nichts was diesen Strang nicht ins falsche akademische Licht setzen würde und wir hinterher wieder zwangsweise in so einen „Stammtisch“ für eingeschränkt und/oder angestrengt Denkende migriert werden an dem ich – so denke ich jedenfalls – dann nicht teilnehme. Deshalb: 🤫

„Was bringt Photoshops neues KI-Feature wirklich?“

Mir gar nichts, weil Abo und Cloud-Bindung völlig inakzeptabel und etwa zehn mal so teuer sind wie Kaufsoftware.

„Denn hierdurch lassen sich KI-generierte Elemente in bereits aufgenommene oder gerenderte Bilder hineinsetzen. Tatsächlich lag auf dem Beitragsbild dieses Artikels gar kein Huhn auf meinem Sofa. Die Statue, das Dach samt Fenster, der Kaffeebecher sowie Zauberstab und Kamera sind ebenfalls KI-generiert.“

Der Hahn ist also von der KI frei erfunden worden?

Ich gehe eher davon aus, dass er aus irgendeinem Foto „magisch“ extrahiert wurde und dann in das neue Bild mit Drag und Drop eingesetzt wurde. Das gab es schon vor 20 Jahren und nannte sich damals nicht KI sondern Fotomontage – oder was genau ist jetzt grundsätzlich anders?

Das, was man früher mühsam mit der Hand gemacht hat, das zurecht Drehen, die Größe, die Farben/Belichtung und Übergänge anpassen, dass macht halt heute die Software automatisch.

Nichts besonderes, aber das Wort „KI“ klingelt halt besser im Geldbeutel.

Diese „automatische“ Funktion wie Du sie beschreibst funktioniert, weil der Computeralgorithmus dahinter selbstlernend ist und trainiert wurde. Fachbegriff: „Machine Learning“.

Meine bessere Hälfte arbeitet in der Forschung schon seit Jahren mit solchen Algorithmen.

Dass umgangssprachlich aus „Machine Learning“ innerhalb zwei drei Jahren zu AI oder auf deutsch KI wurde ist nicht nur die Schuld der Marketingabteilung, sondern auch die Folge unpräziser Journalisten und Influenzer.

Aber grundsätzlich gehört „Machine Learning“ ja schon in die gleiche Familie wie KI: echte KI, also ein Algorithmus der eine höhere Intelligenz, ein eigenes Bewusstsein (umgangssprachlich Singularität) und sich selbstständig vermehren kann wird, falls das irgendwann eintreffen wird, durch selbstlernende Algorithmen entstehen. Machine Learning ist sozusagen die Basis für KI.

Das mit dem Selbstlernend – da wüsste ich gern mal mehr, was man damit meint.

Wenn ich eine Google-Eingabe mache, dann wird lediglich das als Ergänzung vorgeschlagen, was dann in der Vergangenheit am häufigsten eingegeben wurde. Reine Datenbankanalyse. Würde ich nicht als Intelligenz bezeichnen.

Lies einfach nochmal meinen letzten Absatz…

noch etwas ausführlicher: Ich schrieb ja oben der Algorithmus sei „selbstlernend“. Vereinfacht gesagt gibt man dem Algorithmus riesige Mengen von Daten und eine Zielvorgabe, ein bestimmtes Problem zu lösen und der Algorithmus lernt durch Iteration selbstständig, wie er zu diesem Ziel kommen soll. Er soll also Lösungsweg und Methodik selbstständig finden.

Bei einem komplexen Problem und genügend Rechenleistung kann so ein Algorithmus in kürzester Zeit Millionen von Möglichkeiten durchspielen und kombinieren, um das Problem zu lösen. Wäre der Algorithmus nicht selbstlernend müsste man ihm jede einzelne dieser Variante durch Programmierung „beibringen“.

Die KI hat sehr viele Bilder bekommen, die sie als Objekte erkennen musste. Zum Beispiel, immer wenn du ein Captcha gemacht hast, hast du eine KI trainiert, ein Objekt zu erkennen. Nun ist man den Weg gegangen, die KI die Bilder mit dem Transformer zu generieren. Hier lässt man die KI die Objekte wieder als Bild zeichnen. Die KI hat somit die Charakteristiken und Eigenschaften eines Objekts gelernt, indem sie die Gewichte im semantischen Netz für dieses Objekt gefunden hat. Je nach Seed und Variation werden diese Gewichte anders priorisiert. Das kannst du dir ähnlich wie die Temperatur bei Chatbots vorstellen. Die KI macht also nicht einfach Copy & Paste, wie du es dir vorgestellt hast. Die KI hat tatsächlich gelernt, was die Eigenschaften eines Objekts sind. Diese Erklärung ist noch nicht wirklich genau. Falls es dich detaillierter interessiert, kann ich gerne dazu mehr machen oder dir einen Artikel verlinken, falls das erlaubt ist. Es gibt aber auch langweilige Informationspapiere für Entwickler. Ich hoffe, du kannst dir jetzt etwas besser vorstellen, dass es doch deutlich mehr Aufwand ist. Und eine KI muss sehr gut trainiert sein. Man muss ihr immer sagen, was sie nicht machen soll. Man muss sie mit… Weiterlesen »

Also zumindest für Landschaft ist es Spitze, da kann man endlich diese unsäglichen Windräder und überidischen Stromstrassen wegradieren und so tun, als wäre die Landschaft idyllisch und nicht verschandelt.

Woher stammen die Bildinformationen die bei der Umwandlung des Hochkant-Portrait in ein 16×9 Querformat rechts angefügt wurden. Aus dem Foto selbst können diese ja nicht stammen.

Entsprechen diese angefügten Infos den dort original auch vorhandenen Gegebenheiten, dann wissen wir, dass Adobe nach ähnlichen Fotos gesucht und dort die Daten rausgenommen hat.

Oder hat man dort ganz frei irgendetwas angefügt?

„In meinem Beispiel wollte ich auf die Schnelle die großen Stromkabel entfernen, jeweils habe ich dabei die Kabel grob mit dem Polygon-Lasso umrandet.“

Auch da mal eine kleine Rückfrage:

Bei Photoshop Elements gibt es ja die Funktion der Szenenbereinigung. Da werden mehrere Bilder übereinandergelegt und die zu ersetzende durch das Bild laufende Person nur mit einem Pinselstrich markiert. Kein magnetisches Lasso oder andere detaillierte Markierung ist da nötig.

Und es gibt ja auch die Funktionen der Reparaturpinsel, der automatisch die markierten Bereiche mit dem umliegenden Bildinhalt – bei Kabel vor Himmel also die Kabel durch Himmel ersetzt.

Ich könnte mir vorstellen, dass diese Funktion hier ebenfalls verfügbar ist, aber wesentlich ausgefeilter, und vielleicht besser funktioniert, als es hier mit dem Generativen Füllen erreicht wurde.

Das würde ich mir nochmal anschauen.

Ich werde aber wahrscheinlich Luminar anschaffen.

“Was meint Ihr? Wird der aktuelle KI-Trend vorübergehen oder ist das die neue Innovation, auf die wir lange gewartet haben?”

Es ist die logische Weiterentwicklung der bisherigen Editiermöglichkeiten.

Es werden nach und nach alle Programme an Bord haben.

ob es jemanden passt oder nicht, es wird sich nach und nach durchsetzen. Wer den guten alten Zeiten nachtrauert wird gnadenlos überrollt. Es gab und wird auch nie das originale Foto geben, alles ist „künstlich“ erzeugt. Also, nutzt was auf euch zukommt oder ihr werdet abgehängt.

Hey cool, nachdem wir schon im Computer vorgefertigte „Bauklötzchen“ in der Timeline rumschieben können und das Ergebnis als „Musik“ bezeichnen, können wir jetzt auch im Handumdrehen „tolle“ Bilder machen und juhui langweilige Himmel austauschen, interessante Vögel reinkopieren und die olle verrostete Karre im Handumdrehen durch einen Lambo ersetzen.

Auf das habe ich echt gewartet! Echt wirklich.🤪

(Aber wenn ich dadurch ab und zu mal Stromdrähte oder ein Beleuchtungskandelaber schneller aus dem Bild kriege, ok danke.😉)

Das hat jetzt nichts mit Adobe zu schaffen:

Künstlich erzeugte Phantasie Produkte in meinen Bildern? Niemals !! Was ist ein altes Dorf im Osten Europas ohne sichtbare Strom/Telefonkabel? Unglaubwürdig – würde ich sagen. Mirko hat damit ins Schwarze getroffen.

Worum geht es beim Bilder machen eigentlich? Um Authentizität, Geschichten, Reportagen, Familie oder eben um Kunst.

Was nicht funktioniert ist Betrug an dem was wir sehen weil wir seit tausenden von Jahren an Bilder glauben die wir optisch sehen und als Wahrheit einstufen. Habe ich doch selbst gesehen ist der passende Satz dazu.

Nur mal so zum Nachdenken: in der Westschweiz wurde das Wetter ohne das es jemand bemerkt hat im privaten TV von einem Avatar angesagt. Was ist wenn uns „Nachrichten“ von KI Generatoren mit künstlich erzeugten Inhalten Bildern/Videos vorgetragen werden und wir bemerken das nicht?

Die Verlockung mit trendigen künstlichen Videos gezielt Meinungen zu manipulieren ist riesig – der Traum für Machtmenschen würde ich sagen!

Servus Alfred, Bilder sind Zeitgeschichte und dann verstehe ich nicht, wenn die Menschheit in ihrer aktuellen Zeitepoche zB. auf alternativen Energie setzt aber auf deren Bilder (zB. Windräder) nicht erscheinen soll. 😉

👍

Weil Dummheit nicht ausstirbt! Vielleicht haben wir Glück und dieses Kapitel endet in 2 Jahren.

Bilder sind Zeitgeschichte.

Mal mehr mal weniger. Siehe meinen Kommentar. Jeder lebt eben auch in seiner eigenen Welt. Und die Welt ist voller Lügner und Blender. Sozialmedia ist mehr als voll davon.

Nur wenn man den oben genannten Personen dies ins Gesicht sagt kommen sofort tausend Ausreden und wenn es diese ist:

Andere machen das doch auch.

Es ist aber auch ein Unterschied ob man sich eine Traumlandschaft erstellt oder bewusst manipulieren will und wenn, zu welchem Zweck.

V.G. K..

Hallo Alfred, 👍 war ja klar, dass wir da 100% Deckungsgleich liegen 👍 es ist ein Schreckensszenario – die Programme sind nur die Vehikel um den Illusionsmüll zu transportieren und uns (positiv) eine schönere Illusion oder (negativ) brutal zu manipulieren. Wie ich schon öfter schrieb: mir reichen die „10 Basiswerte-Schieberegler“ für die Postproduction – Reichen die nicht, habe ich „kein Bild welches meinem Anspruch entspricht“ und bin im Regelfall der der es nicht hinbekommen hat. Punkt.

Bilder wurden schon seit immer und weig manipuliert, auch wenn nicht mit der neuesten Technik. Wer jetzt aufschreit, der hat wohl in einer Nussschale gelebt.

🤔 Mmmh, ich kann mich gut an den ersten Kingkongfilm erinnern. Man konnte klar erkennen – es ist Trick. Ich kann mich an den zweiten, dritten usw. erinnern und jedesmal wurde es besser, bis man heute nicht mehr erkennen kann, das es Tricks sind. Da wir aber (hoffentlich) alle wissen, dass es weder Godzilla noch Kingkong gibt ist dies kein Problem – bei zeitgeschichtlicher Reportagearbeit ist dies aber nicht so. Wir können nicht direkt einordnen ob der Papst eine weiße, dicke Daunenrobe trägt oder nicht und da wir nicht mehr direkt erkennen, dass es Täuschung ist, wird es seeehr schwierig …

Woher weisst Du, dass es KingKong und Godzilla nicht gibt?

Gute informierte Quellen berichten, dass die immer Freitagabends zusammen mit Yeti und Nessi pokern und den Whiskey vernichten, den Nessi aus Schottland mitbringt.

Aber Spass beiseite: dein letzter Satz beschreibt sehr schön die Herausforderung, die auf uns als Gesellschaft zukommt.

🤔 Mmh, auch wieder „wahr“! 😉

Was mir noch dazu in den Sinn kommt: was gemacht werden kann, wird gemacht. Klar Du kannst dich dem verweigern, was ich nachvollziehen kann. Ich mag meine Bilder auch mit der Kamera komponieren und nicht am Computer, aber wenn ich die Entwicklung in der Öffentlichkeit anschaue, sind wir wohl eine Randgruppe.

All die tollen Filter und Apps, die auf Instagramm und Co. die Alltagsbilder der Leute „aufhübschen“ sind Legion.

Noch eine kleine Anekdote: Ich sah mal vor Jahren (vor AI) ein TV Magazin in der Kioskauflage mit einem Gesicht einer Dame drauf. Irgendwie kam mir die Dame bekannt vor, aber irgendwie war es auch irritierend, bis ich die Schlagzeile dazu las: es war Barbara Schönenberger, mit Photoshop bis zur fast Unkenntlichkeit verhunzt…

Hallo Peter, natürlich habe/hätte ich null Problem mit all den Dauer-HDR-Sonnenuntergängen ohne Stromleitungen, Papierkörbe und „störende Menschen?“ usw., wenn es denn dabei bliebe.

Aber die Kombination aus „perfektionierter Täuschung“, „viral gehender Sekundenperformance“ und „visueller Dauerbeschallung“ ergibt ein böses Szenario.

Vergleiche mit Colorieren, Ausschnitten in den Anfängen und der folgenden 150 Jahre der Analogzeit, hinken vor Allem aufgrund der heutigen „Performance der Verbreitung“ von perfekt manipulierter Unwahrheit(en).

Da ist die Barbara nur eine Statistin in dieser rasanten Entwicklung – zumal ja jede(r) (ohne Fachkenntnisse) jede(n) innerhalb von Minuten dadurch im Netz diskreditieren kann.

Es bleibt schwierig.

„Aber die Kombination aus “perfektionierter Täuschung”, “viral gehender Sekundenperformance” und “visueller Dauerbeschallung” ergibt ein böses Szenario.“

Das bringt es auf den Punkt. Dazu noch gefakte Studien und Presseberichte auf Knopfdruck und in ein paar AI Generationen auf Knopfdruck gefälschte Videos und wir haben den Salat.😉

Verblüffend echte Stimmfälschungen von echten Menschen sind, mit genügend Trainingsmaterial, heute schon möglich, inkl. Pausen, Phrasierung, Atmer usw.

Es bleibt spannend…

So isses!

da täuscht Du dich aber. Schon im Vietnamkrieg wurden Bilder manipuliert. Da wurde halt einfach das Foto zugeschnitten um Inhalte die einem nicht passen, wegzunehmen. Heute geht es über KI

Ja, das funktionierte über weglassen. Kann man auch noch einfacher haben, indem man z.B. eine Sache in den Nachrichten gar nicht thematisiert.

Die neue Qualität ist aber, dass man innert Sekunden neue Inhalte dazu erfinden kann und das dies auch problemlos von Laien machbar ist.

Die virtuelle Realität ist in der Realität angekommen…

Man kann und darf alles machen was möglich ist, dennoch sollte man auch angeben was gemacht wurde, sofern Dinge ausgetauscht oder hinzugefügt werden. Bei FC ist es üblich anzugeben ob Stacking oder KI eingesetzt wurde.

Siehe meine Posts …

… jetzt stehe ich auf dem Schlauch, konnten nun die Affen bei „Planet der Affen“ richtig sprechen oder war das auch wieder alles Fake ???

Die Frage ist eher – Wer war der Affe – Charlton Heston oder Dr. Cornelius 🤔

Also genetisch sind Schimpansen zu 99.4% identisch zu Menschen.

Weitere Spekulationen überlasse ich euch…😆

Also über so eine alberne Frage kann ein gebildeter Mensch wie ich (Einbildung ist auch eine Bildung) wirklich nur den Kopf schütteln, lieber Mirko. Wenn ich auf dem Schlauch stehen würde ginge ich da ganz schnell runter, so was muss doch weh tun? Wer sich so allgemein bildet wie ich, der schaut auch des öfteren solche Polit-Labersendungen im Fernsehen, da kommt einem hinterher die Frage, ob Affen reden können nie nicht wieder in den Sinn. Also, Freund Mirko, lerne von einem klugen Mann: Affen können natürlich reden, wieso einige Affen dann meinen, deshalb könnten sie auch regieren, dass wissen die selber nicht. Die Oberaffen (also King-Kong für MFT-Sensor), die müssen nicht mal reden können, die haben sogar einen Pressesprecher. Aber sagt mal wegen dieser KI und dem ganzen Gedöns, ist es wirklich die Frage, was man kann oder was nicht? Mir stellt sich eher eine ganz andere Frage zu diesem Thema: Was ist, wenn es wegen solcher „Verbesserungen“ dann einen Geschädigten gibt, also es soll ja Leute geben, die nicht wie ich als Hobbyist aus Spass an der Freude Faken sondern dies eben gewerbsmäßig zur Erzielung von Einkünften betreiben. Wie immer ein Beispiel, erspare Euch mal wieder nichts: Ich buche… Weiterlesen »

„Was ist wenn uns „Nachrichten“ von KI Generatoren mit künstlich erzeugten Inhalten Bildern/Videos vorgetragen werden und wir bemerken das nicht?“

Das merken die Leute doch schon seit Jahrzehnten nicht, wenn sie von den Staatsmedien von vorn bis hinten belogen werden. Zu Deutsch: Das Problem ist, das die Leute nichts hinterfragen. Die haben die wichtigsten allgemein bekannten Infos, wie zum Beispiel dass Deutschland nach der Schlacht bei Stalingrad militärisch mit dem Rücken zur Wand stand und die Westalliierten trotz wiederholter Bitten der Regierung der Sowjetunion im Westen keine Front aufgemacht hatten, nicht parat.

Ohje, tut ja richtig weh. Da lass‘ ich mich lieber von einer KI unterhalten, da entzünden sich wenigstens nicht gleich die Hirnwindungen, wenn einem solch Stuss erzählt wird. Hinterfragen ist gut, kann man bei sich selbst auch mal anfangen. Übrigens ist es immer umgekehrt: das Huhn im Beitragsbild, von dem du meinst es sei irgendwo ausgeschnitten, hat nie existiert – im Gegensatz zum Corona-Virus, dessen Existenz du verneinst. Trage deine Theorie zur Pandemie doch beim nächsten Italienurlaub den Menschen in Bergamo vor. Aber sicherlich weißt du es auch besser als die Betroffenen. Beim nächsten Historikertag kannst du bestimmt auch glänzen…

Ich fotografiere so.

Ein Schloss fotografiere ich so, dass die Müllcontainer der Schlossküche nicht mit drauf sind. Das ist sozusagen Lügen durch weglassen.

Ich fotografiere einen schönen Ausschnitt. Dass es vor Ort nicht ganz so schön aussieht, das ist auf dem Bild nicht drauf.

Mir geht es darum, schöne Bilder zu haben.

Der Modellbahnfreund baut seine Modellbahnen auch so. Dort ist nur die Sonnenseite des Lebens zu sehen.

Um Menschen zu täuschen benötigt man die moderne Technik nicht.

Es genügt, den Überbringer der Nachricht als seriös oder als Fachmann wirken zu lassen.

Und so war eben früher die Erde eine Scheibe – ganz ohne moderne Computertechnik.

In Deutschland sterben im Quartal etwa 250.000 Menschen ganz normal im statistischen Durchschnitt. Im ersten Quartal 2020 genügten über die Medien gemeldete ca, 20 angebliche Coronatote, um einen Großteil der Menschen hierzulande einzureden, wir hätten eine Pandemie und sie zu ängstigen.

🍿

Tja, die einen fluchen und meckern darüber. Die Anderen freut es und wieder andere finden es bedenklich.

Ein paar Stromkabel oder ne weggeworfene Flasche entfernen, da geht der Disput schon los. Ich persönlich würde die Kabel der Straßenbahn nicht entfernen. Diese gehören zu den Gleisen. Nen Affen ins Bild zaubern, ein lustiger Scherz.

Aber, aber man kann sich nicht mehr sicher sein, daß ein Bild auch wirklich etwas dokumentiert, oder ob eine Aussage durch Manipulation geändert wurde. Diese Grenze fällt gerade absolut und für immer.

Leider wird eben auch die Glaubwürdigkeit von Nachrichten immer weiter untergraben. Aussage und Gegenaussage werden sich in naher Zukunft unwiederlegbar gegenüberstehen.

Ansonsten soll jeder machen was er will. Jeder hat einen bestimmten Anspruch an sich selbst. Den eigene Anspruch an andere sollte man in den Wind schießen. Rückgrat ist umso mehr gefragt.

Als die Leute früher Bilder in Öl gemalt haben konnten Sie auch Dinge malen die es nicht gab und waren Künstler.

Ich sehe da kein Problem KI und Fotografie zu verbinden und dennoch kreativ und künstlerisch zu sein.

Also ich sehe da schon ein ganz gewaltiges Problem, nicht wegen irgendwelcher künstlichen Kunstbilder, nicht mal wegen der KI, mein Problem kommt aus dem Gerät hinter dem Gerät, da lauert eine riesige Gefahr für die Menschheit. Wenn so ein Maler sagen wir „das jüngste Gericht“ malte, dann mußte der, um Sachen zu malen, die es nicht gab eines haben, Fantasie. Diese Fantasie generierte der Künstler zwischen den Ohren, selbst schweinische Fantasien müssen ja aus dem Hirn kommen, woher den sonst, der Pinsel ist immer nur das Werkzeug. Wenn wir ein Bäuchlein bekommen oder die Muskel lustlos rummhängen, dann rennen wir in die Muckibude, aber, wenn unser Denkorgan verfault, dann nehmen wir dies nicht einmal war, mit was auch? Es ist auch nicht einmal die Gefahr, dass KI irgendwann die Herrschaft übernehmen wollte, wieso sollte KI etwas wollen, es kann aber passieren, dass KI irgendwann dazu erzogen werden muss, weil viel zu viele die Herrschaft über sich selber verloren haben. Erst brauchen wir ein selbstständig drehendes Smartie, weil Anwender zu dumm sind zu erkennen, was bei dem Ding hinten und vorne ist, dann eines, dass Nachts auf dem Bett liegt und uns mit „einatmen, ausatmen“ am Leben hält und wenn der… Weiterlesen »

Habe mir das mal genauer angeschaut, das hat nix mehr mit Fotografie zu tun. Was willst du noch auf dem Bild haben, das nie da war und was willst du weghaben was drauf war. Ok, kann man mögen, aberich hoffe, dass das gekennzeichnet werden muss.

Ehrlich gesagt hoffe ich dies auch, allerdings nur bedingt.

Es gibt Lügner und es gibt Betrüger, lügen darf man, betrügen nicht.

Deshalb sehe ich eine Kennzeichnungspflicht beim reinen Lügner als Eingriff in die persönlichen Freiheiten des Lügenmauls, Betrug hingegen muss unterbunden werden.

Mit der Frage eines Geschädigten, also z.B. wenn ein junges Mädchen in der Pupertät Probleme bekommt, weil es vergleicht und immer nur Mädels sieht, die im wahrsten Sinne des Wortes „zu schön um wahr zu sein“ sind, damit sollen sich unsere Juristen hier befassen, nicht meine Baustelle, weswegen ich hierzu nichts schreibe.

Mir kommt das vor, als würden ehrliche Sportler gegen Gedopte antreten. Man sollte einfach zwei Kategorien machen. Sozusagen gedopt und nicht gedopt! Unter gedopt zähle ich erweitern, hinzufügen oder entfernen. Beschneiden, Helligkeit, etc gehört noch zu ungedopt!

„ehrliche Sportler?“

Aber lieber Joe, Du hast mich ganz schön enttäuscht, bin dem J.F. oben mal zur Seite gesprungen wegen der Meinung eines Akademikers über uns „eingeschränkt denkende Menschen“.

Nun hatte ich ja so gehofft, Du würdes wegen wissenschaftlicher Verwandtschaft dem Herrn zur Seite springen, da ich einen Verdacht habe, wer es ist hätte ich mir dann sicherlich vor Lachen in die Hose gepinkelt, trotz eher noch nicht vorhandener Inkontinenz, hätte Dir aber dann meinen Verdacht mitgeteilt, denn wenn Mark nicht schnell genug gewesen wäre hätte das Material dann sicherlich für eine Doktorarbeit zum Thema „wissenschaftliche Kraftausdrücke in der modernen Gesellschaft“ gereicht.

Ach ja, mein Freund, Dummland ist nicht überall verblödet, gib mal in Deine Suchmaschine

„Wenn ein Clown in einen Palast einzieht“ ein, dann müßtest Du auf einen Beitrag und ein Plakat kommen, welches Dir zumindest einen Teil Deines Glaubens an Dein Vaterland wiedergibt.

Hoffe, ich habe Dir ein Lächeln ins Gesicht gezaubert, leider brauche ich keine Produkte von Krafft, sonst hätte ich was bestellt!

Es gibt ehrliche Sportler, nur kennt die keiner, weil sie sich zwangsläufig hinter den Gedopten einreihen. So wird es bald in der Fotografie aussehen, die Schummler stehen vorne.

Die Anzahl der „ehrlichen Sportler“, die dürfte auf Ebene einer WM gegen Null gehen, die sehen die meisten Sportbegeisterten nicht. Was ist ehrlich? Der Herr Hauptmann oder die Frau Kommisarin, die als Hobbyisten durchgehen, wo fängt Ehrlichkeit an, wo hört sie auf? Ich bin ein Oberschummler, oder eben auch nicht, brauche auch nichts zu kennzeichnen, denn wer meine Bilder für „aus der Kamera“ hält, der glaubt auch, dass Zitronenfalter Zitronen falten. Mal eine typische Bildbeschreibung zu meiner Darstellungsart: Mache Bilder von einem ehemaligen Kloster, möchte einen Teil der dunkelen Vergangenheit dieses Gigabauwerks darstellen, aus der Zeit, als dort eine „Idiotenanstalt“ drinne war und man die armen Menschen auch genau so behandelte, wie das Wort schon klingt. Also soll das Bild eine die Luft abdrückende Stimmung ausdrücken, der Betrachter soll das Elend sehen, jeder Betrachter kann in den Suchmaschienen leicht entdecken, dass hinter dem Örtchen Kiedrich noch nie die Welt untergegangen ist, selbst wenn meine Bilder „beschissen“ wären hätte ich ja niemanden „beschissen“, was jeder wissen sollte kann ja kein Betrug sein. Anders rumm: Wenn in großen Marketingprofiläden ganze Heerscharen von Werbepsychologen zusammen mit den von Dir gerne empfohlenen Hirnforschern den „Gabentisch“ bereiten, alles perfekt gemacht, wie es sich am besten… Weiterlesen »

Ich würde mir keine Sorgen machen wegen der KI Integration in Bildern.

Warum?

Weil es nicht die Realität ist.

Wir benötigen immer die Realität zur Interaktion.

Wie bei allen Hypes geht auch dieser vorüber.

Was bleibt ist die Realität und reale Produkte von Menschen für Menschen.

Wir brauchen immer den Bezug zur Realität.

Daher sind die Produkte die die Realität 1:1 abbilden immer wertvoller als die künstliche Interpretationen.

Und zwar egal wie schlecht sie sind im Vergleich sind.

Dazu muss man auch kein Phonograph sein.

Warum darf man ein Weinglas nie ganz voll schenken?

Ganz einfach: Im Wein liegt Wahrheit und die volle Wahrheit kann keiner ertragen.

Bei mir unterm Fenster tobt gerade „die Rückkehr der motorisierten Leichen (Teil was was ich).“

Bin mir ziemlich sicher, die Damen und Herren haben mächtig viel Spaß, aber eines wollen die aber weiß Gott nicht wissen: Die Realität!